撕开《鱿鱼游戏》中恐怖AI的面具

在广受欢迎的《鱿鱼游戏》系列中,AI扮演了什么角色?我们将何去何从?

广受欢迎的《鱿鱼游戏》(Squid Game)在世界各地的新闻媒体和社交媒体上掀起了一股巨大的热潮,这部剧及其受欢迎程度可以从很多方面来理解,尤其是在剧中使用的AI对科技爱好者的吸引力,因为如果没有它们游戏中的许多元素就不可能出现。

01 AI真的很重要

要管理这些致命游戏,技术,尤其是AI是关键元素。首先,如果没有数据库和智能过滤和搜索算法,参与者的选择是不可能的。搜索引擎的前后都需要软件工程师,而且必须为“未来”的参与者使用推荐系统。

接下来是实际的游戏,第一个游戏被翻译为“红灯绿灯”,但游戏的直译应该是“Mugunghwa( 木槿花,韩国的国花)开花了。”这个名字是“它”背对着重复的短语。从系列中可以看出,规则也略有不同。当“它”重复这个短语时,玩家可以移动,但是当“它”转身时必须冻结,不然你就输了(或者在系列赛中被瞬间杀死)。

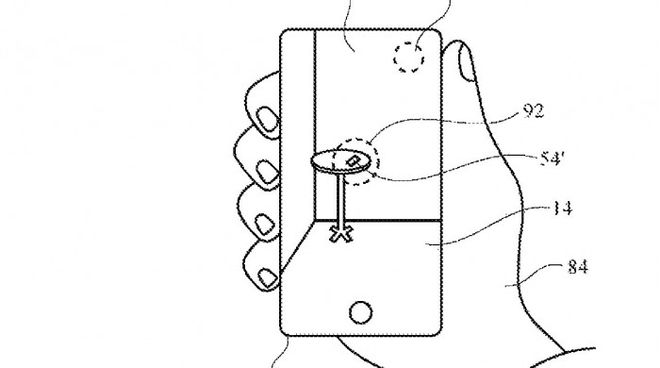

《鱿鱼游戏》中的“它”实际上是一个有着两个变焦镜头眼睛的巨型机器人,每当它转过身来扫描参与者时,它都试图检测运动。如果有人移动,这个人就会被识别出来,并用遥控步枪精确地射击。这涉及到几种技术,令人害怕的是,所有这些技术都很容易获得。

1、运动检测:这很容易做到,只需几行Python代码就可以完成。

2、人脸识别:将某物检测为人是一项目标检测任务,使用深度学习非常容易(例如YOLO)。另一方面,识别那个人是谁需要更多的工作,但是只要你收集一些训练图像就可以完成。

3、机器人:墙上有几支遥控步枪。这些步枪似乎没有安装任何传感器,所以我假设视觉信息来自机器人的眼睛。信息必须至少包含目标的位置、距离和姿态。用摄像机校准每支步枪不是小事,但可以做到,近期由美国“幽灵机器人”(Ghost Robotics)公司和“宝剑国际”(SWORD International)公司联手打造的战斗机器狗就是很好的例子。

对于这款游戏来说,AI技术尤为重要,因为它能够提供一种“公平感”。想象一下,这款致命游戏是由真人扮演“IT”,而游戏职员则是这场射击游戏的操作者,要在疯狂的人群中高精度地射击一个移动的个体,即使是顶尖的狙击手也难以办到,同时人类不可能同时准确而公平地跟踪和检测这么多人的运动,无法保证游戏的公平性。

但有了AI这些问题都可以被克服。当人类“它”叫你出来时,你会争辩。当人工智能机器人检测到动作并开枪时,没有人提出争议,AI没有感情不会对任何个体产生偏颇(但存在偏见),所以看起来AI是这款游戏必不可少的,但却不是最终解决方案。

02 AI不是最终解决方案

AI虽然重要,但是它可能会成为一个邪恶的工具。

在我看来,《鱿鱼游戏》生动地描述了AI如何被富人和有权有势的人用作另一种方便的工具来剥削弱势群体。作为一名软件开发人员和人工智能研究人员,我所从事的、有时引以为豪的工作可能会变成如此邪恶和暴力的东西,这是一个可怕的想法。

许多人工智能研究人员也有同感。YOLO (You Only Look Once)是当今最流行的目标检测模型之一,由约瑟夫·雷德蒙(Joseph Redmon)开发。2017年,他在一场广受关注的TED演讲中自豪地展示了自己的最新作品。

然而,一年后,他发现自己的算法被军方使用,在中东和世界各地追踪并杀害了成千上万人,这让他感到恐惧。例如去年一名伊朗核科学家在去年(2020年)被AI机枪打死,今年(2021年)8月,阿富汗平民被一架军用无人机炸死。

去年乔治·弗洛伊德(George Floyd)去世之后,人工智能中的偏见成为了一个大讨论话题。我们现在意识到,人工智能可能和人类一样有偏见,甚至更有偏见。问题可能来自多个层面:例如,倾斜的数据集、训练期间超参数的轻微扰动、转移的域或恶意的对抗攻击,但总归一句话:AI存在偏见。

03 为什么AI也有偏见?

首先得明白一点:今天的人工智能模型通常是预先训练好的,并且是开源的,这使得研究人员和公司都可以快速实施人工智能,并根据他们的具体需求进行调整,这是AI存在偏见的根源所在。

虽然这种方法使人工智能更加商业化,但也有一个真正的缺点,即少数模型现在支撑着各行业和各大洲的大多数人工智能应用。这些系统被未检测到的或未知的偏见所困扰,这意味着为他们的应用调整这些系统的开发者是在一个脆弱的基础上工作。根据斯坦福大学基础模型研究中心最近的一项研究,这些基础模型中的任何偏见或它们所依据的数据都会被使用它们的人继承下来,从而造成错误被放大的可能性。

例如,YFCC100M是Flickr的一个公开数据集,通常用于训练模型。当你检查这个数据集中的人物图像时,你会发现世界各地的图像分布严重偏向美国,这意味着缺乏来自其他地区和文化的人的代表。

训练数据中的这些类型的倾斜导致人工智能模型在其输出中存在代表性不足或过度的偏见--也就是说,输出中白人或西方文化更占优势。当多个数据集被合并以创建大型训练数据集时,缺乏透明度,要知道你是否有一个平衡的人、地区和文化组合会变得越来越困难。由此产生的人工智能模型被公布,其中包含令人震惊的偏见,这并不奇怪。

此外,当基础的人工智能模型被公布时,通常很少甚至没有围绕其局限性提供信息。解开潜在的问题是留给最终用户来测试的,这一步往往被忽略了。如果没有透明度和对特定数据集的全面了解,要发现人工智能模型的局限性是很有挑战性的,例如对妇女、儿童或发展中国家的表现较差。

04 如何减少AI的偏见

AI存在偏见是不争的事实,它既不能被消灭也不能被忽视,当前部分从业者为了获得更强大的模型,往往会选择更大的训练数据,从而牺牲了对数据中的偏差和偏见的理解。人工智能中的偏见并非小事,在未来几年将需要整个科技行业的合作,目前已有从业者采取一些预防措施了。

例如Getty Images,他们要求对其授权的创意内容进行模型公布,这使他们能够在元数据(即描述其他数据的一组数据)中包含自我识别的信息,从而让人工智能团队能够在数百万张图片中自动搜索,并迅速识别数据中的偏差。开源数据集往往因缺乏元数据而受到限制,在将多个来源的数据集合并以创建一个更大的数据池时,这个问题就更严重了。

还有部分从业者在基础模型发布时同时发布相应的数据表,描述基础训练数据,提供数据集中内容的描述性统计。这样做将为后来的用户提供一个模型的优势和局限性的感觉,使后来者能够做出明智的决定。

另一个互补的方法是让人工智能开发者能够获得一个已知偏见和基础模型的常见限制的运行列表,包括开发一个容易获得的偏见测试数据库,人工智能研究人员使用这些模型可以有效预防AI偏见,就像《鱿鱼游戏》中的AI从不偏袒任何人一样。

本文来自微信公众号“Techsoho”(ID:scilabs),编辑:Light,出品:科技智谷,36氪经授权发布。